¿Chile, el penúltimo país en lavado de manos? No, no era tan así

Un estudio de un equipo de académicos de diversas universidades apareció citado en un informe de Espacio Público y luego por el Minsal. Había que mirar más que un gráfico.

Fue en un punto de prensa el 27 de mayo cuando el entonces ministro de Salud, Jaime Mañalich, proyectó un mapa de colores. Tras el reporte diario de casos de contagios, fallecidos y otros indicadores de la pandemia del Covid-19, agregó que había un estudio que “evaluó a varios países en el mundo” y ante “la pregunta ‘¿Usted se lava las manos frecuentemente?’, el 74% de la gente dice que sí. Pero tenemos un cuarto de la población que sigue actuando como de costumbre”.

Ministro Jaime Mañalich | Estudio lavado de manos pic.twitter.com/zay8D4bb53

— Ministerio de Salud (@ministeriosalud) May 27, 2020

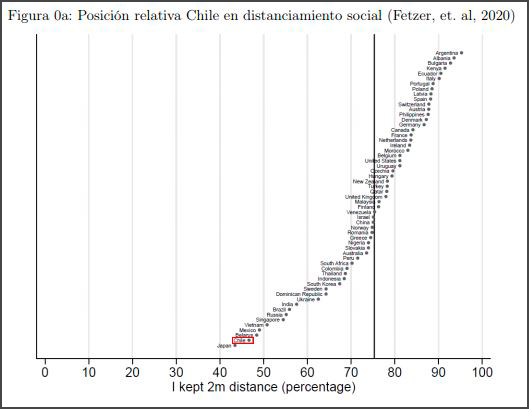

Luego, el ministro mencionó otra consulta de aquel estudio, relacionada con el distanciamiento físico: “Solamente la mitad de las personas en Chile dice que está haciendo medidas nuevas, adecuadas a la situación sanitaria que vivimos, lo que nos deja en una situación muy preocupante”.

Ministro Jaime Mañalich | Estudio distanciamiento físico pic.twitter.com/gJU8XOefXd

— Ministerio de Salud (@ministeriosalud) May 27, 2020

En ambos casos se refería al documento “Global Behaviors and Perceptions at the Onset of the Covid-19 Pandemic“, firmado por 14 investigadores encabezados por Thiemo Fetzer, economista de la Universidad de Warwick, del Reino Unido. Fue publicado como working paper (documento de trabajo) en la reconocida organización de investigación económica NBER.

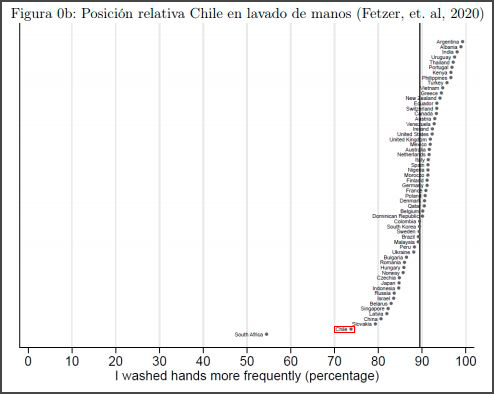

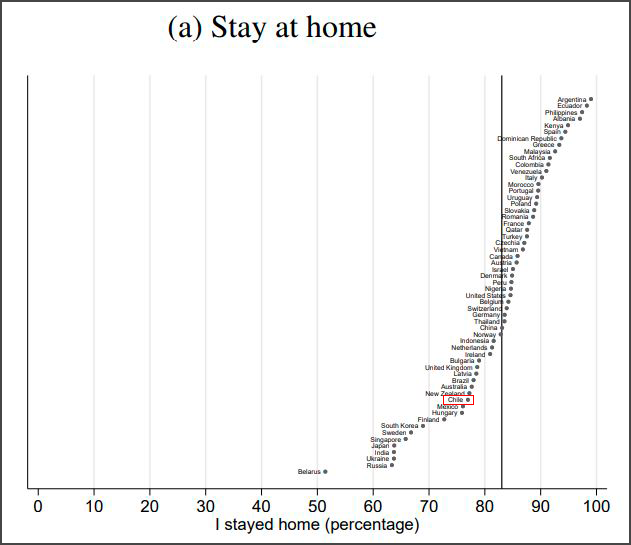

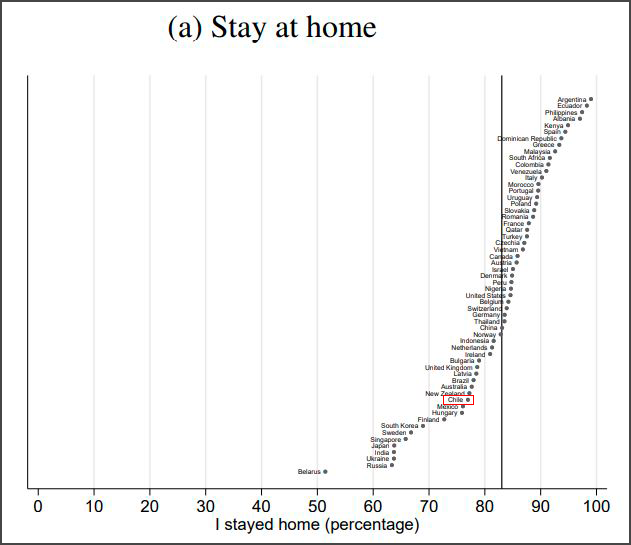

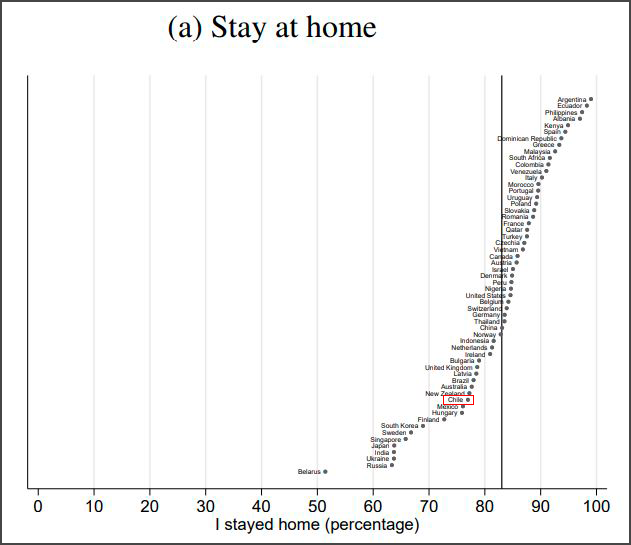

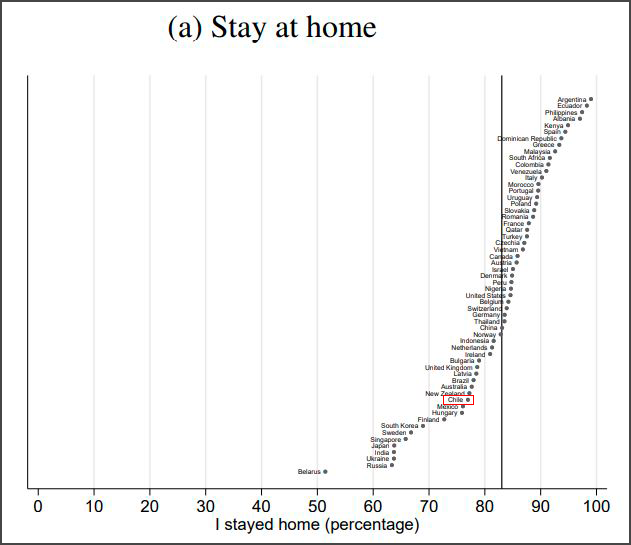

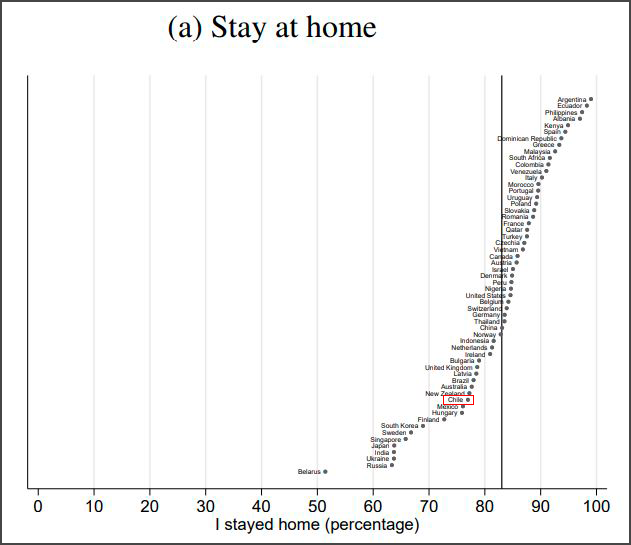

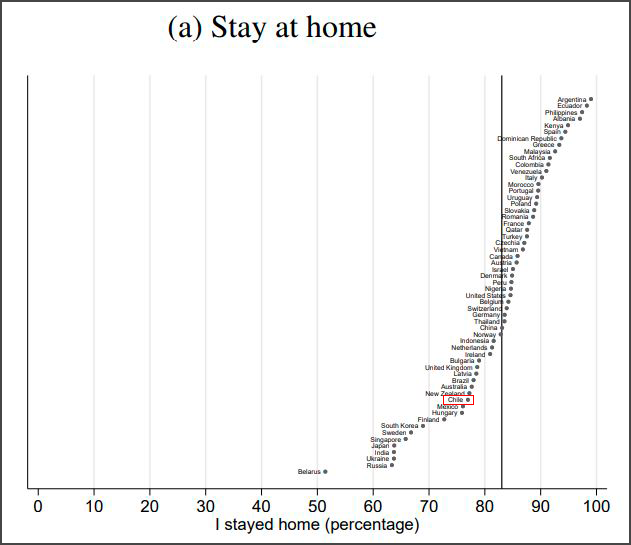

El Gobierno no fue el primero en hablar de ese estudio. Fue el think tank Espacio Público el que incluyó esos mismos datos en su informe del 13 de mayo. Su síntesis: “En un trabajo de Fetzer y coautores, publicado la semana pasada por el NBER, se puede apreciar que Chile es el penúltimo en un universo de 58 países en el respeto al distanciamiento social y el lavado de manos”. Acompañaba dos de los gráficos que vienen en el paper, y que se reproducen abajo.

¿Y entonces?

Pero la conclusión a la que muchos llegaron al ver las imágenes ignora algunos elementos que cuestionan la metodología de ese estudio.

En primer lugar, cuando el estudio habla de distanciamiento “social”, lo hace respecto de una pregunta sobre si la persona ha mantenido dos metros de distancia con otros. Dos metros. En las recomendaciones del Ministerio de Salud y de la propia Organización Mundial de la Salud (OMS), la medida es de un metro. Por lo tanto, resulta obvio que muchos más chilenos respondieran que no han mantenido dos metros de distanciamiento físico, pues no es la sugerencia oficial; de haber sido consultados por un metro de distancia, ¿hubiesen respondido lo mismo? En la lámina desplegada por el exministro Mañalich no se aclara cuál fue la pregunta original.

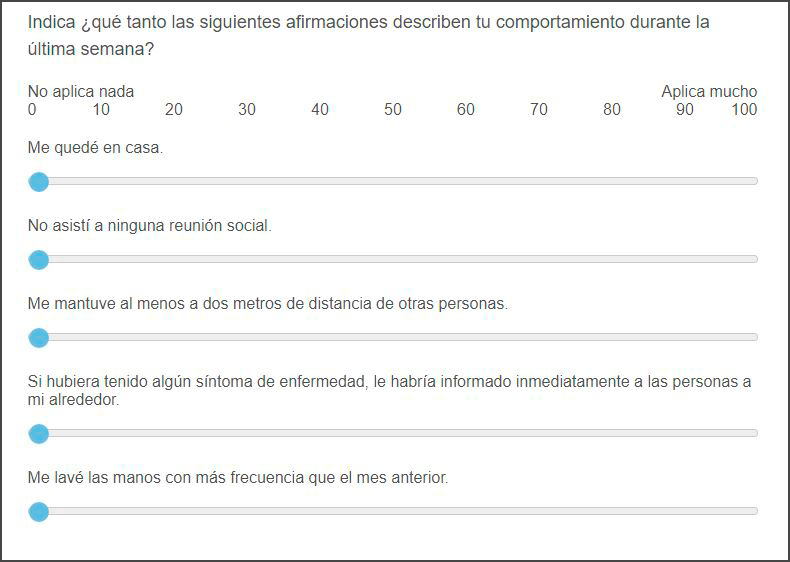

En segundo lugar, en relación con el lavado de manos, la pregunta hecha a los participantes no es respecto de cuántas veces al día se lavan las manos, como se insinúa en las gráficas. La consulta es: “Me lavé las manos con más frecuencia que el mes anterior”. Es un fraseo complejo, pues si acaso la persona ya el mes previo se lavaba mucho las manos, ¿qué ocurre si después se las lavó “tanto” como entonces?

No es lo único.

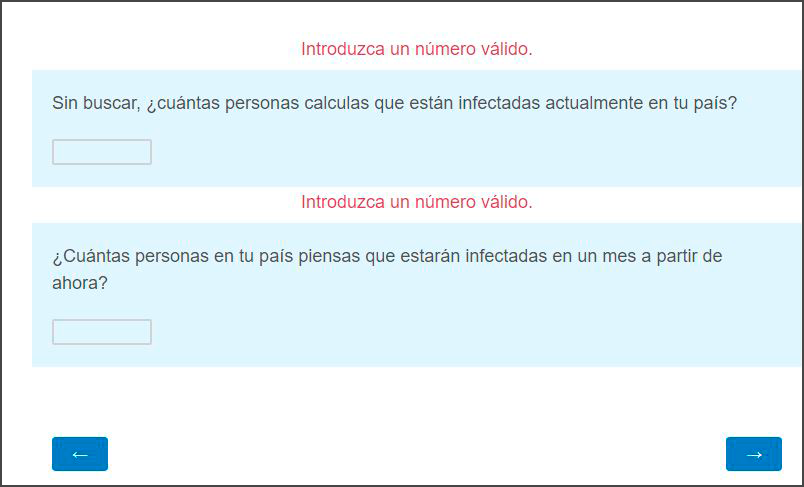

Los encuestados carecen de la opción de no contestar algunas preguntas (equivalente a la categoría “No sabe/no responde” usual en los sondeos). Incluso el sistema les exige que introduzcan números estimados de contagios actuales y futuros; si el participante no responde, no puede seguir con las otras consultas.

Hay dudas también acerca del tipo de muestreo utilizado. Resulta que se trata de una encuesta compartida por redes sociales, que descansa sobre la base de la técnica de recolección de “bola de nieve”: mientras más personas se enteran, más respuestas se van recogiendo. Es un sistema de recolección de datos validado en las ciencias sociales, aunque siempre deben quedar claros los eventuales sesgos, como el de comunidad (“invito a participar a personas como yo”). Como no es un muestreo probabilístico, tampoco permite inferencias sobre la población objetivo.

En este caso, existe una sobrerrepresentación de personas con acceso a internet, con interacción en ciertas redes sociales y con el tiempo e interés de responder.

Ante estos escenarios, los investigadores suelen realizar una “corrección” de los datos para intentar una mejor representación del universo poblacional que buscan reflejar. En el caso de Fetzer y otros, usaron ponderadores conocidos, como algunos obtenidos del Banco Mundial o de la encuestadora global Gallup.

“En general, no podemos decir nada estadísticamente válido basado en este estudio”, resume para PAUTA una investigadora especialista en metodología cuyas conclusiones se detallan más adelante.

Pero no, sigue sin ser esto lo único. Antes, sin embargo, daremos un rodeo.

Un gráfico sí, otros gráficos no

El director ejecutivo de Espacio Público, Diego Pardow, quien es además uno de los coautores del informe del 13 de mayo de ese think tank (junto con Camila Arroyo, Eduardo Engel y Pablo Simonetti), dice que no observó especialmente la base de datos del estudio citado. “Pero sí sabemos que tiene un muestreo no aleatorio ni probabilístico, que tiene sus dificultades”, reconoce. “Lo leímos y nos pareció que era un tema que había que destacar e incluir en el informe”. Plantea que se trataba de una materia de interés reflejar las diferencias entre el cumplimiento de medidas básicas de protección con una desconfianza en el Gobierno.

En el informe de Espacio Público, en todo caso, no se indican advertencias sobre los alcances metodológicos del estudio.

Tampoco se incluyeron otros de los gráficos detallados por países que están en el documento en NBER. Por ejemplo, se muestra a Chile con casi 78% de cumplimiento ante la pregunta de si la persona se quedó en casa, pese a que en esas fechas el país estaba entre los pocos con cuarentenas dinámicas y no totales.

Pero tampoco insertaron gráficos, ni el Minsal los desplegó en reporte del 27 de mayo, que dan cuenta de que efectivamente Chile estaba, según esta medición, entre los países con menor percepción de confianza en el Gobierno, ya sea porque la reacción gubernamental fue insuficiente, no confía en que mantendrá a salvo a los ciudadanos o porque cree que no ha sido del todo honesto sobre el Covid-19.

Asimismo, no se refleja otro gráfico que trae el estudio de Fetzer, relacionado con que si acaso la “reacción pública” ha sido insuficiente.

Ahora bien, todos, absolutamente todos los gráficos expuestos hasta aquí están en el Apéndice del paper de Fetzer y otros. Cuando material de este tipo está en un apéndice en un trabajo académico no significa que sea inútil, pero sí revela que es secundario respecto de los resultados centrales que están en el cuerpo principal del paper.

Y en ese cuerpo principal solo hay un gráfico desagregado y explicitado por países, incluido Chile. Se trata de uno en que se aborda la pregunta de si la respuesta del Gobierno ha sido muy extrema. Allí Chile aparece entre aquellos con mayor porcentajes de respuestas positivas (casi 38%). Se trata de un gráfico que debería ser leído como el opuesto a aquel sobre la respuesta “insuficiente” del Gobierno. Lo que este paper no muestra es el porcentaje de quienes contestaron que la reacción del Gobierno fue “apropiada”, donde son muchos más los países con porcentajes mayores que el de Chile.

Pero, ¿sirve acaso alguno de estos gráficos si sus bases metodológicas son deficientes?

Cuando no se lee la metodología

Diego Pardow dice que tomaron algunas de las conclusiones del estudio porque lo que se buscaba era ilustrar un panorama general. “Es distinto un informe [el de Espacio Público] que se hace tres veces a la semana a un paper enviado a referenciar”, expresa. Con ello se refiere el circuito que siguen las investigaciones serias: surge una duda, se postulan hipótesis, se investiga sobre la base de una metodología clara, se evalúan las hipótesis a partir de la evidencia recogida, se proporcionan conclusiones, se envían a una revisión de pares (por ejemplo, a una revista científica) y, si pasan ese último corte, se publica para nutrir el conocimiento general.

La investigadora y epidemióloga María Paz Bertoglia, de la Escuela de Salud Pública de la Universidad de Chile, tuvo una lectura del paper de Fetzer y otros distinta a la de Espacio Público.

“No es un muestreo probabilístico, por lo que no puedes hacer inferencia poblacional. Solo publicaron los países que acabaron 200 respuestas o más. No sabemos cuántos países quedaron fuera. Así y todo, la mayoría de las respuestas de quienes respondieron de Chile son buenas. Solo dos respuestas fueron bajas, una de ellas (45%) se explica porque preguntaron si se habían mantenido a menos de dos metros (nuestras campañas se enfocaron en un metro); la otra, si se lavaron las manos más que el mes anterior (70%), lo que puede ser sesgo de memoria y probablemente ahora la responderían mucho más alta”, resume. “Es un ejercicio interesante. Pero no es una publicación final ni tampoco pueden usarse esos resultados para hacer inferencia a toda la población”, reitera.

Por lo mismo, su crítica al uso de esos datos es general: “Varios medios de comunicación, incluido el Gobierno, usaron esos datos. En titulares y en una conferencia de prensa oficial”.

Qué dice el investigador del estudio

El 28 de mayo PAUTA escribió a Fetzer por correo electrónico, pero el autor no respondió el mensaje.

Con posterioridad, este medio consiguió hablar con el investigador encargado de aclarar las dudas: Jon Jachimowicz, profesor asistente de la Escuela de Negocios de la Universidad de Harvard.

Representatividad de la muestra

Jachimowicz reconoce que la técnica estadística de ponderar los factores para países con muestras grandes (en este caso, el Reino Unido o Estados Unidos) puede ser distinto que con muestras pequeñas (como sucede en este estudio con Irlanda, Noruega, Uruguay y Chile, por dar algunos ejemplos). La muestra de Chile hasta ese momento era de 551 participantes.

“Las reponderaciones son, por definición, más precisas cuando la muestra es más diversa y representativa de la distribución de la población subyacente, lo que puede ser una función del número de respuestas, pero probablemente no está correlacionado linealmente con ella”, contesta.

En el paper, los autores contrastaron sus ponderaciones con las de otro panel (Prolific) usado en otras investigaciones para hacer un chequeo de la robustez de sus resultados; pero solo aplicaron ese chequeo con el Reino Unido y Estados Unidos. Entonces, ¿pueden los mismos ponderadores reflejar bien el universo de países con un menor muestreo y evitar así los sesgos de recolección de la técnica de la “bola de nieve”?

“No podemos responder definitivamente esa pregunta con nuestros datos actuales. Sin embargo, este resultado sugiere que, al menos en el Reino Unido y los Estados Unidos, nuestra estrategia de muestreo abarcó estratos de población”, señala Jachimowicz.

Ese tema es importante. En la pregunta del lavado de manos, la ponderación para Chile afectó el resultado. Mientras en el gráfico exhibido por el informe de Espacio Público y la lámina del Minsal y numerosos reportes de prensa se muestra que solo el 74% de los chilenos “se lava las manos más frecuentemente”, un promedio simple de la muestra de Chile (sin ponderaciones) lleva el indicador a otro resultado: el 95,2% de la población sí se lavó las manos más que el mes previo.

Consultado acerca de esta diferencia, el investigador dice que la ponderación, “tal como mencioné, es una función del muestreo y no necesariamente del número de encuestados. Es difícil para mí decir cuán precisos son los datos de cualquier país”.

Confección de preguntas

-Consideraron que en muchos países (por ejemplo, Chile, que siguió las recomendaciones de la OMS) las autoridades han recomendado mantener una distancia interpersonal de un metro?

“No, no lo hicimos. Nosotros lanzamos la encuesta el 20 de marzo en un momento cuando muchos gobiernos aún estaban tratando de averiguar qué pautas implementar”.

-La pregunta en la encuesta dice: “Me lavé las manos con más frecuencia que el mes anterior”. ¿Cómo lidian con el hecho de que las personas podrían lavarse las manos con tanta frecuencia como el mes anterior? Por lo tanto, para ellos no sería posible lavarse las manos más que un máximo posible.

“Tenga en cuenta que nuestro marco de tiempo de muestreo es del 20 de marzo al 7 de abril; esta pregunta, por lo tanto, se aplica del 20 de febrero al 7 de marzo, un período de tiempo en el que la mayoría de las personas no estaban particularmente preocupadas por Covid-19”.

-¿Sobre qué base el equipo de investigación asumió que la mayoría de las personas no estaba particularmente preocupada con el Covid-19 en ese momento?

“Montones y toneladas de datos de encuestas, pero también no viene al caso. El argumento es que las personas estaban más preocupadas del 20 de marzo al 7 de abril que entre el 20 de febrero y el 7 de marzo”.

-Pero esta encuesta todavía está abierta. ¿Han considerado modificar la pregunta sobre el lavado de manos?

“Sí, pero decidimos no cambiarla”.

-El título del gráfico presentado en su paper dice “Lavarse las manos más regularmente”. ¿No es diferente de la pregunta que se les hizo a los participantes?

“Sí, tiene razón, esto debería leerse ‘con mayor frecuencia’, pero con frecuencia es sinónimo de regular, por lo que no creo que sea una gran preocupación”.

Análisis comparativo

El investigador señala que en su sitio web http://covid19-survey.org/ se utiliza un ordenamiento de los países según las categorías consultadas a las personas que participaron. Lo que se despliega allí es un mapa de colores, que incluyen los resultados una vez corregidos por los mismos ponderadores que Jachimowicz reconoce no poder aplicar con precisión para países como Chile.

“Todos los análisis se realizan a nivel de comparación entre países y no distribuimos análisis para cada país individual”, plantea el académico.

El análisis de comparación entre países (cross-country analysis) es una poderosa herramienta en las ciencias sociales, que permite evaluar similitudes y diferencias entre distintos casos. A partir de ese ejercicio, si está bien validado, se pueden obtener conclusiones sobre tendencias que pueden ser relevantes. Sin embargo, ese elemento no parece bien recogido del paper de Fetzer y otros.

-Esto me cuesta entenderlo: si el análisis no se hace para cada país, ¿cómo es que en el sitio web al que se refiere podemos ver los mapas que clasifican a los países (mapeo de colores)?

“Los análisis se realizan a nivel comparativo de países. Esta imagen corresponde a un promedio ponderado con fines ilustrativos”.

¿Y qué diría un par revisor?

PAUTA sometió este estudio a un análisis experto. Para ello este medio se contactó con Edith de Leeuw, académica del Departamento de Metodología y Estadísticas de la Universidad de Utrecht, en Países Bajos, quien fue editora y colaboradora del International Handbook of Survey Methodology publicado por la Asociación Europea de Metodología.

De Leeuw parte felicitando a los autores del paper “por la descripción pormenorizada del estudio y los detalles metodológicos. Este informe es un buen ejemplo de la transparencia que tanto valoramos en la ciencia”. Pero habiendo dicho eso, resume que “la mayor debilidad de este estudio es, por supuesto, que los encuestados se seleccionaron a sí mismos (autoselección) y que no fueron seleccionados a través de un proceso de probabilidad (aleatorio)”.

Representatividad de la muestra

“Una encuesta web se utiliza para recopilar los datos en todos los países. Sin embargo, la penetración de internet varía considerablemente entre países”, explica la especialista. La penetración de la red es distinta entre continentes, pero también dentro de una misma región: en Chile, dice, llega al 77,5%, pero en República Dominica es de 61,1%, según datos de Internet World Stats. “Por lo tanto, en países con una baja penetración de internet, una parte importante de la población no está cubierta por la encuesta web”, sostiene.

No es lo único: “El acceso a internet está relacionado, entre otros, con la edad, el género y la educación. A través de la ponderación de estas variables, se intenta corregir el equilibrio (como se hizo en este estudio), pero esto no es una garantía. Una mujer de 80 años en Chile que tiene acceso a internet es probablemente diferente de una mujer de 80 años en Chile sin conexión a internet, a canales de noticias, búsqueda de información, en conocimiento y creencias sobre el coronavirus, etcétera”.

Luego existe otra materia que debería hacer sonar las alarmas de cualquier estudioso de métodos de investigación en encuestas: la tasa de no respuesta.

En un paper como el de Fetzer y otros no es posible determinar la tasa de no respuesta de una forma tradicional, “porque se desconoce el tamaño de la población original. Este estudio es una encuesta no probabilística basada en la autoselección de los encuestados que reaccionaron a un mensaje en las redes sociales. Pero los autores son muy transparentes e informan el número total de personas que fueron a la página (como reacción a los mensajes en las redes sociales): 391.476. De estos, solo el 40% (157.264) comenzó el cuestionario. De los que comenzaron el cuestionario, 112.136 (71%) completaron el cuestionario”, describe De Leeuw. Es decir, una de cada tres personas que iniciaron el cuestionario interrumpieron el proceso, lo que “podría deberse a que estaban menos interesadas, o se cansaron o se irritaron porque, como usted observó, las preguntas eran obligatorias; uno tenía que responder y no podía saltar una pregunta si no estaba seguro de su respuesta”.

Si se ve todo el conjunto contactado, “de todas las personas que leían la invitación de las redes sociales y se tomaron la molestia de ir a la página de destino, solo el 29% completó el cuestionario. Y, por supuesto, no sabemos cuántas personas leyeron la invitación en las redes sociales para la encuesta y no fueron a la página de destino. Es por eso que no se puede calcular un porcentaje de respuesta […] Una gran N (número de cuestionarios completados) no dice nada sobre la representatividad de las respuestas”, recalca.

Confección de preguntas

Uno de los problemas visibles de la encuesta es que en varias preguntas no se permite seguir adelante si no se contesta, por ejemplo, cuál es la estimación que hace el participante del número de contagiados en su país.

El uso de preguntas obligatorias, enfatiza en mayúsculas De Leeuw, “NO es una buena práctica, aunque desafortunadamente muchas encuestas aún lo hacen. La naturaleza obligatoria podría muy bien ser una de las explicaciones de la baja tasa de respuesta”. Hay evidencia acumulada que demuestra que las preguntas obligatorias tienden a hacer que las personas no sigan respondiendo un cuestionario, indica la investigadora.

Y, cómo no, está el error de medición: ¿Qué tan bien la pregunta utilizada midió el concepto pretendido, y cuán confiable y válida es la medición resultante? “A primera vista, las preguntas publicadas en el informe están bien, pero no sabemos exactamente cómo fueron traducidas e interpretadas por el encuestado”, reflexiona la investigadora. Da como ejemplos las preguntas sobre el distanciamiento físico, que apuntan a países cuyos gobiernos han dado recomendaciones diversas: “¿La gente no leyó la pregunta cuidadosamente e interpretó la pregunta como ‘distancia social requerida’? ¿Usó una forma de satisfacción? ¿O se tradujo la pregunta de tal manera que reflejara la medida real en un país?”, inquiere De Leeuw.

Análisis comparativo

Los ponderadores utilizados tampoco son útiles. Y no lo son no porque no segmenten por edad, sino porque no está clara la variable de interés, plantea De Leeuw. Tampoco sirve que Fetzer y otros hayan usado un panel (Prolific) para Estados Unidos y el Reino Unido que les pemitiera chequear la representatividad de la muestra. “La verificación de robustez no es válida. La mayor debilidad del muestreo es que es una muestra autoseleccionada (no probabilística). Si usted va al sitio web de Prolific, verá que Prolific también utiliza una muestra no probabilística“, cierra.

“Prolific ofrece muestras representativas, por lo que esa afirmación es falsa”, retruca Jon Jachimowicz.

De nada sirve desde el punto de vista específico un estudio cuyos principales elementos no pueden ser validados. Ocurre con el valor p, que según sea su cifra permite descartar si un resultado es fruto de la casualidad, o la significancia estadística que determina si hay errores de muestreo, y así.

“Para poder usar estadísticas y dar intervalos de confianza alrededor de porcentajes y calcular valores p y pruebas de significación estadística, se necesita un muestreo probabilístico. Así que, en general, no podemos decir nada estadísticamente válido basado en este estudio”, comenta Edith de Leeuw: “Normalmente, en una muestreo basado en probabilidades, se pueden calcular los intervalos de confianza en torno a un porcentaje y luego clasificar el orden, por ejemplo, en los países. Aquí no podemos hacer nada estadísticamente válido en este sentido”.

En un paper publicado en enero de este año en el Journal of Survey Statistics and Methodology, Carina Cornesse y otros 11 autores (incluyendo De Leeuw) discuten precisamente sobre cuáles son las mejores prácticas para recoger inferencias a partir de modelos probabilísticos y no probabilísticos.

Por otra parte, la experta en diseños de sistemas de salud Mirella Cacace, académica de la Universidad Católica de Ciencias Aplicadas de Friburgo, dice a PAUTA que los cuestionarios de una encuesta deben tener una especial sensibilidad con sus adaptaciones culturales. Por lo mismo, sugiere que los investigadores consideren las guías de la OMS y su proyecto de Encuestas en Entrevistas de Salud (HIS, en inglés), en práctica entre los especialistas del sector al menos desde 1997.

Por todo lo anterior, prosigue De Leeuw, “no puedes ordenar en un ranking a los países con tanta precisión. Aunque probablemente se puede hacer una diferenciación muy global en los datos, también lo hace entre países con alta y baja adhesión, pero no entre países con una adhesión de 70% y 74%”, ilustra.

“En resumidas cuentas”, precisa, “de aquellas personas en países de todo el mundo que tenían acceso a internet y vieron la invitación en las redes sociales y fueron a la página de inicio y abrieron el cuestionario y completaron el cuestionario, de esas personas autoseleccionadas, el 74% de la gente en Chile dijo que se lavaban las manos con más frecuencia que el mes anterior. No se puede estimar a partir de estos resultados qué tan grande es ese porcentaje para todas las personas en Chile. Lo mismo ocurre con los otros países”, concluye.

Lo que sí se puede obtener del estudio: una dirección

“Una de las conclusiones importantes es que la encuesta pretende medir el impacto poblacional de la comunicación de riesgos, y la necesidad de que las autoridades reconozcan que sus acciones tienen consecuencias a la salud poblacional”, sostiene Bertoglia.

Ese es, precisamente, el punto de mayor énfasis de Diego Pardow, de Espacio Público. Por lo mismo, cree que el uso del Gobierno de láminas con información incompleta del estudio no implica un falseamiento. “No. Las autoridades sanitarias deben echar mano de distintos elementos para reforzar los mensajes y saber qué está bien; y si algo está mal, evaluarlo”, dice.

Eso sí, Edith de Leeuw refuerza lo que debería ser la conclusión general: “Básicamente, es un lindo estudio y las conclusiones incluidas en su resumen probablemente estén bien, pero uno no puede interpretar los porcentajes en los países como representativos para el país debido a la autoselección de los encuestados. Por lo tanto, no se puede clasificar de manera válida el orden de los países tan precisamente como se hace en algunos de los gráficos. Solo pueden mirarse como indicadores aproximados”.